速递|OpenAI亚洲布局第三站:韩国ChatGPT付费第二,继日本、新加坡后设立办事处

图片来源:Unsplash OpenAI 已在韩国成立法律实体,旨在推动其人工智能技术的进一步普及。其在 5 月 26 日发布的声明中表示,计划未来几个月内在首尔设立办公室,并正在招聘员工以支持与企业和政策制定者的合作关系。 韩国是除美国以外 ChatGPT 付费用户数量最多的国家。 这将是 OpenAI 在亚洲设立的第三家办事处,此前已在日本和新加坡...

3家大型网站平台被处罚!中央网信办:强化“开盒”整治工作|快讯

文| 李玲 对于组织煽动“开盒”、提供“开盒”服务等账号、群组,将一律予以关闭或者解散。 5月27日,据中央网信办消息,中央网信办近日专门印发通知,从阻断“开盒”信息传播、完善预警机制、加大惩治力度、优化保护措施、加强宣传引导 等多个维度明确工作要求,督促各地网信部门、各网站平台进一步强化“开盒”问题整治工作。 同时,中央网信办召开专题部署会议,要求微博、...

小米辟谣玄戒O1芯片向Arm定制,雷军也发声了|快讯

文| 林文琪 5月26日晚,小米在《小米15周年产品答网友问》中辟谣新推出的芯片玄戒O1“非自研是向半导体公司Arm定制的芯片”。小米表示“这完全是谣言,玄戒O1不是向Arm定制的。”随后雷军也在微博恳请大家转发辟谣,并表示玄戒O1最高主频为3.9GHz,这足以说明芯片团队具备相当强的研发设计实力。 南都记者了解获悉,近期传闻源自于Arm一篇标题为“小...

Dify中的预定义模型插件开发例子:以siliconflow为例

本文使用Dify v1.0.0-beta.1版本。模型插件结构基本是模型供应商(模型公司,比如siliconflow、xinference)- 模型分类(模型类型,比如llm、rerank、speech2text、text_embedding、tts)- 具体模型(比如,deepseek-v2.5)。本文以siliconflow为例,介绍Dify中的预定义模...

Dify中的自定义模型插件开发例子:以xinference为例

本文使用Dify v1.0.0-beta.1版本。模型插件结构基本是模型供应商(模型公司,比如siliconflow、xinference)- 模型分类(模型类型,比如llm、rerank、speech2text、text_embedding、tts)- 具体模型(比如,deepseek-v2.5)。本文以xinference为例,介绍Dify中的自定义模型...

Dify中的Agent策略插件开发例子:以Function Calling为例

本文使用Dify v1.0.0-beta.1版本。Agent 策略插件能够帮助 LLM 执行推理或决策逻辑,包括工具选择、调用和结果处理,以更加自动化的方式处理问题。Dify官方实现的Agent策略插件包括Function Calling和Reason+ReAct(Reason+Act)。本文重点介绍Function Calling具体实现。 一.初始化插件...

Dify中的Extension插件开发例子:以neko为例

本文使用Dify v1.0.0-beta.1版本。以neko为例,介绍Dify中的Extension插件开发例子。需要说明的是Dify官方要求Python≥3.12,但发现本地PyCharm调试Python≥3.12有问题,就采用的Python 3.11版本。 一.Extension插件项目创建 1.填写插件信息 按照提示配置插件名称、作者信息与插件描述。如...

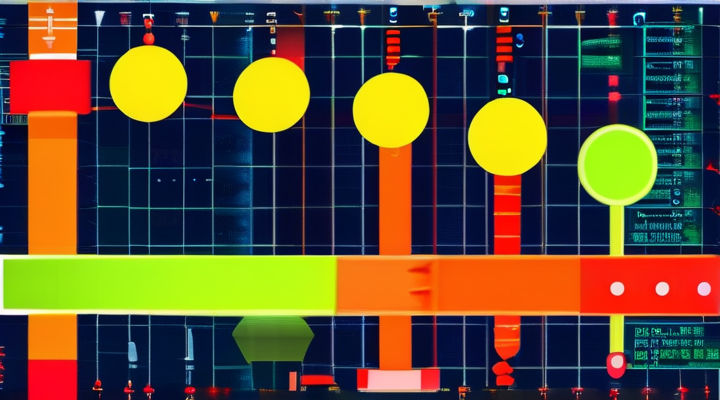

dify-api的.env配置文件

源码位置:dify\api\.env 本文使用Dify v1.3.1。配置文件中各变量的详细信息表,如下所示: 变量英文名 变量中文名 默认值 变量功能 SECRET_KEY 秘密密钥 XXX 用于安全地签署会话cookie的应用秘密密钥。确保在部署时使用强密钥。 CONSOLE_API_URL 控制台API基础URL htt...

RAGFlow源码安装操作过程

RAGFlow是一款基于深度文档理解构建的开源 RAG(Retrieval-Augmented Generation)引擎,可作为Dify的外部知识库使用[1]。本文主要介绍RAGFlow前端和后端等源码安装操作过程。 一.后端安装 特别注意:python = ">=3.12,<3.13"。 1.安装Poetry curl -sSL https:...

一套LLM幻觉检测工具:uqlm

一套LLM幻觉检测工具:uqlm,给了多种评测方式来检测AI输出幻觉,可以根据不同的场景选择合适的方法 1、黑盒评分器,通过多次生成并比较同一提示的回复来评估一致性。就反复问同一个问题,如果每次回答的核心意思不一致或差异很大,说明它可能在瞎编 2、白盒评分器,利用token概率估计不确定性。查看LLM对自己答案中每个部分的自信程度,如果它对某个词或句子很不确...