阿里巴巴同元实验室发布MAI-UI:一款超越Gemini 2.5 Pro、Seed1.8和UI-Tars-2的Android平台基础GUI代理家族。

阿里巴巴通义实验室发布了MAI-UI——一家基础GUI代理的家族。它本地理解MCP工具使用、代理用户交互、设备-云协作和在线RL,在一般GUI基础和移动GUI导航方面取得了最先进的结果,超过了AndroidWorld上Gemini-2.5-Pro、Seed1.8和UI-Tars-2。该系统针对早期GUI代理常忽视的三个特定差距:原生代理用户交互、MCP工具集成以及一个在需要时仍使用大型云模型的设备云协作架构,同时保持设备上敏感工作的隐私。

https://arxiv.org/pdf/2512.22047

什么是MAI-UI?

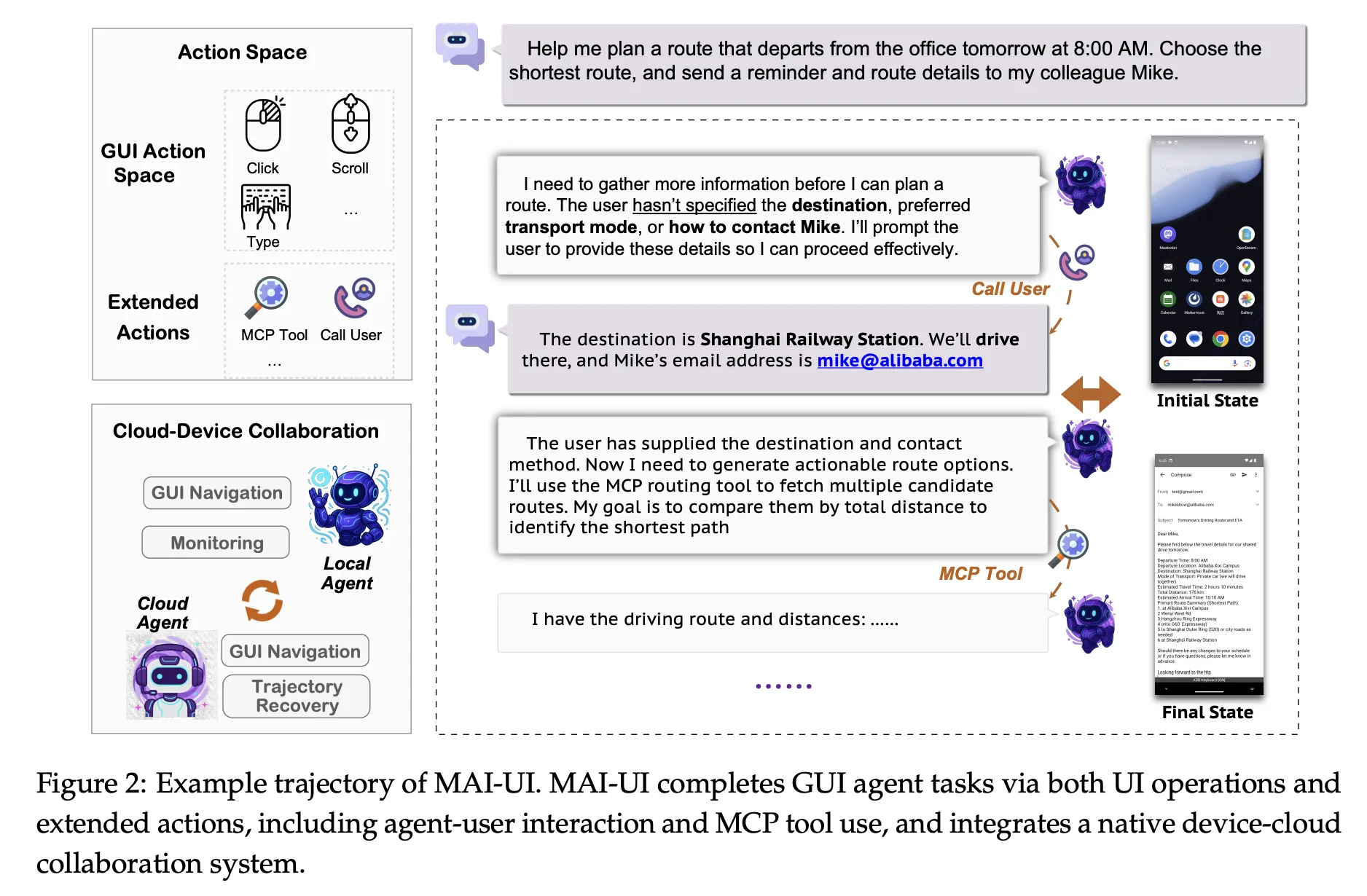

MAI-UI是基于Qwen3 VL构建的多模态GUI代理家族,模型大小为2B、8B、32B和235B A22B。这些模型以自然语言指令和渲染后的UI截图为输入,然后为实时Android环境输出结构化动作。

动作空间涵盖了标准操作,如点击元素、滑动、输入文字和按系统按钮。在此基础上,MAI-UI还引入了回答用户问题的显式动作,在目标不明确时向用户请求澄清,并通过MCP工具调用来调用外部工具。这使得代理能够在一个轨迹中对GUI步骤、直接语言响应和API级操作进行混合。

从建模角度来看,MAI UI统一了三个组件:一个包含用户交互和MCP案例的自主演化导航数据管道,一个扩展到数百个并行Android实例和长上下文在线RL框架,以及一个根据任务状态和隐私约束路由执行的本地设备云协作系统。

https://arxiv.org/pdf/2512.22047

使用指令推理进行GUI接地

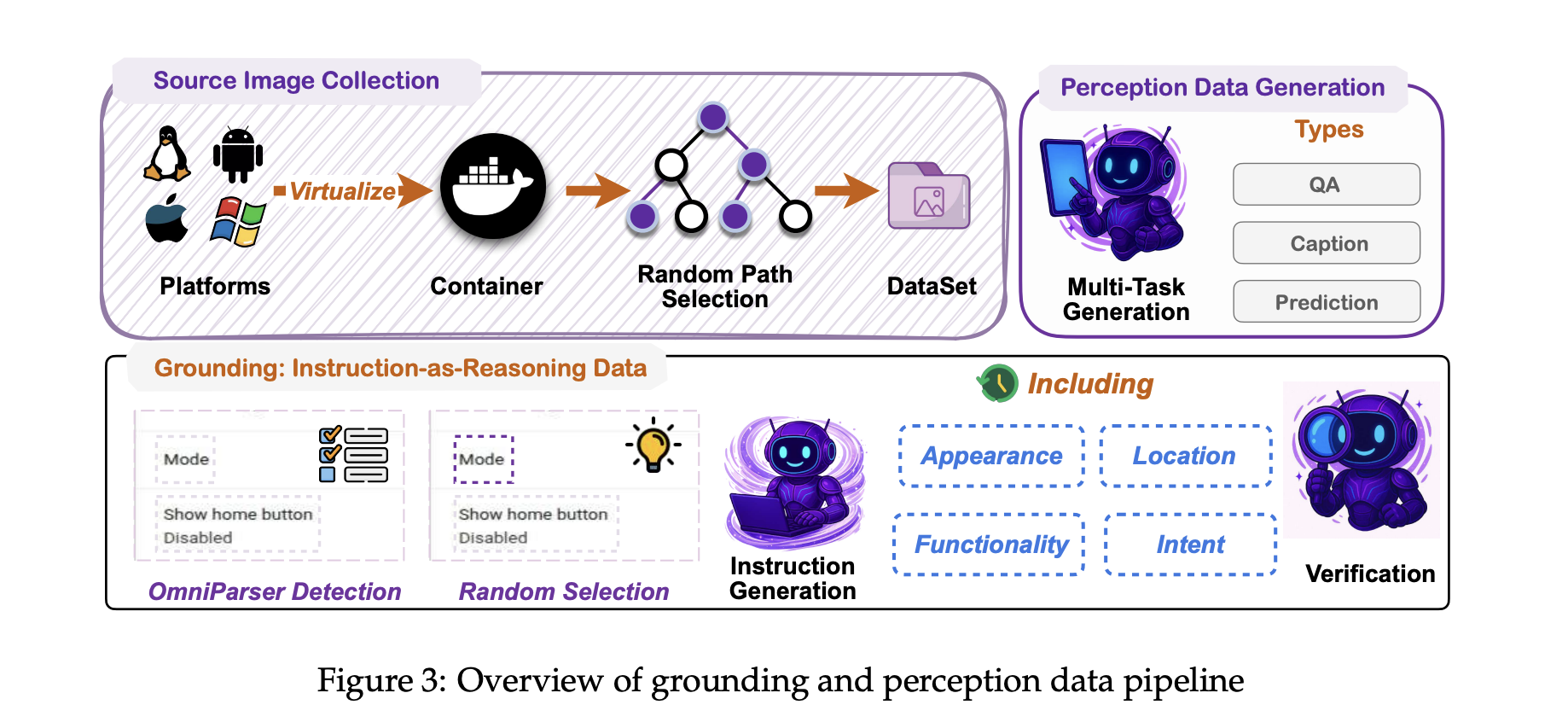

任何GUI代理的核心要求是接地,将诸如“打开每月账单设置”之类的自由格式语言映射到屏幕上的正确控制。MAI-UI采用了受早期UI-Ins关于多视角指令描述工作的UI接地策略。

对于每个UI元素,训练管道不依赖于单个字幕。相反,它生成相同元素的多个视图,例如外观、功能、空间位置和用户意图。这些多个指令被视为模型推理的证据,模型必须选择正确边界框内的一个点。这减少了指令有缺陷或不详尽的影响,这是UI Ins在现有数据集中量化的问题。

真实世界盒子是从一系列精心挑选的GUI数据集和大型虚拟化操作系统在容器化环境中的大规模探索中收集的。使用可访问性树或基于OCR的解析器将文本元数据与像素位置对齐。训练目标结合了监督微调和简单的强化信号,该信号奖励盒子内正确点预测和有效的输出格式。

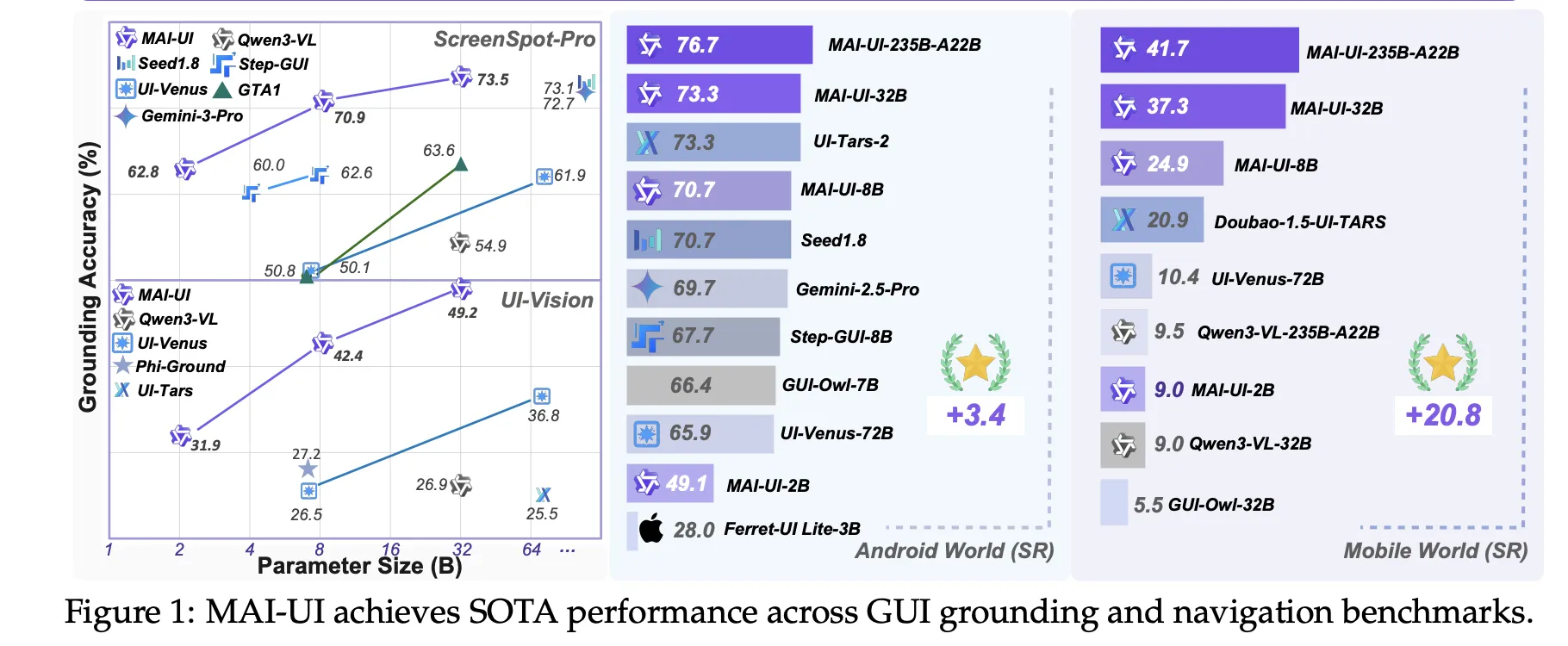

在公共GUI接地基准测试中,MAI-UI模型达到ScreenSpot Pro的73.5%准确性(自适应缩放),MMBench GUI L2的91.3%,OSWorld G的70.9%,UI Vision的49.2%。这些数字在ScreenSpot Pro上超过了Gemini 3 Pro和Seed1.8,在UI Vision上显著优于早期的开源模型。

https://arxiv.org/pdf/2512.22047

自演化导航数据和MobileWorld

导航比接地更困难,因为代理必须在多个步骤中保持上下文,可能在不同应用程序之间进行用户和工具交互。为了构建强大的导航行为,通义实验室使用自演化数据管道。

Seed任务来自应用手册、手工设计的场景和过滤后的公共数据。日期、限制和筛选值等参数被扭曲以扩展范围,并应用对象级别的替代方法,同时保持相同的用例。多个代理以及人类标注员在Android环境中执行这些任务以产生轨迹。然后,裁判模型评估这些轨迹,保留最长正确的前缀,并过滤掉低质量的段落。接下来的监督训练轮次使用新鲜的人类轨迹和高质量模型 rollout的并集,因此数据分布逐渐遵循当前策略。

MAI UI在MobileWorld基准测试上进行了评估,该基准测试来自同一团队,包括20个应用程序中的201个任务。MobileWorld明确混合了三个类别:纯粹的GUI任务、需要与用户进行自然语言来回交互的代理用户交互任务,以及需要工具调用的MCP增强任务。

在MobileWorld上,MAI UI达到41.7%的整体成功率,比最强的端到端GUI基线高约20.8个百分点,与使用更大的专有规划器(如Gemini 3 Pro)的代理框架具有竞争力。

容器化Android环境中的在线RL

静态数据不足以在动态移动应用程序中获得鲁棒性。因此,MAI-UI使用直接与容器化Android虚拟设备交互的在线RL框架。环境堆栈将根植AVD映像和后端服务打包到Docker容器中,通过服务层公开标准的重置和步骤操作,并支持来自电子商务、社交、生产力和企业类别的35多个自托管应用程序。

RL设置使用verl之上实现异步on policy方法GRPO,类似于Megatron风格的训练,这使得模型可以学习包含长达50步和非常长令牌序列的轨迹。奖励来自基于规则的验证器或模型裁判,它们可以检测任务完成,以及对于明显的循环行为的惩罚。只有最近的成功轨迹才保留在特定任务的缓冲区中,以稳定学习。

实际操作中,扩大该RL环境非常重要。研究团队表明,将并行GUI环境的数量从32个增加到512个可以使导航成功提高约5.2个百分点,并将允许的环境步骤从15步增加到50步增加约4.3个百分点。

在AndroidWorld基准测试中,该测试评估了标准Android应用套件中的在线导航,最大的MAI UI变体达到76.7%的成功率,超过了UI-Tars-2、Gemini 2.5 Pro和Seed1.8。

主要结论

- 用于移动的统一GUI代理家族:MAI-UI是从2B到235B A22B的Qwen3 VL基础GUI代理家族,专门设计用于实际的移动部署,包括本地的代理用户交互、MCP工具调用和设备云路由,而不仅仅是静态基准。

- 最先进的GUI接地和导航:模型在ScreenSpot Pro上达到73.5%,在MMBench GUI L2上达到91.3%,在OSWorld G上达到70.9%,在UI Vision上达到49.2%,并在AndroidWorld移动导航上达到新的76.7% SOTA,超过了UI Tars 2、Gemini 2.5 Pro和Seed1.8。

- 与交互和工具的MobileWorld表现逼真:在具有20个应用程序的201个任务的MobileWorld基准测试中,MAI UI 235B A22B达到41.7%的整体成功率,在纯GUI任务上达到39.7%,在代理用户交互任务上达到51.1%,在MCP增强任务上达到37.5%,超过了最佳的端到端GUI基线Doubao 1.5 UI TARS的20.9%。

- 容器化Android中的可扩展在线RL:MAI-UI在容器化Android环境中使用基于在线GRPO的RL框架,从32个并行环境扩展到512个环境可以使导航成功提高约5.2个百分点,并将环境步骤预算从15步增加到50步再增加约4.3个百分点。

查看论文和GitHub存储库。您还可以关注我们的Twitter,并不要忘记加入我们的100k+ ML SubReddit和订阅我们的时事通讯。等等!您在telegram上吗?现在您也可以加入我们的telegram群组。

本文由MarkTechPost首先发布。原文链接。