Meta AI发布Segment Anything Model 3(SAM 3)以实现图像和视频中的可提示概念分割

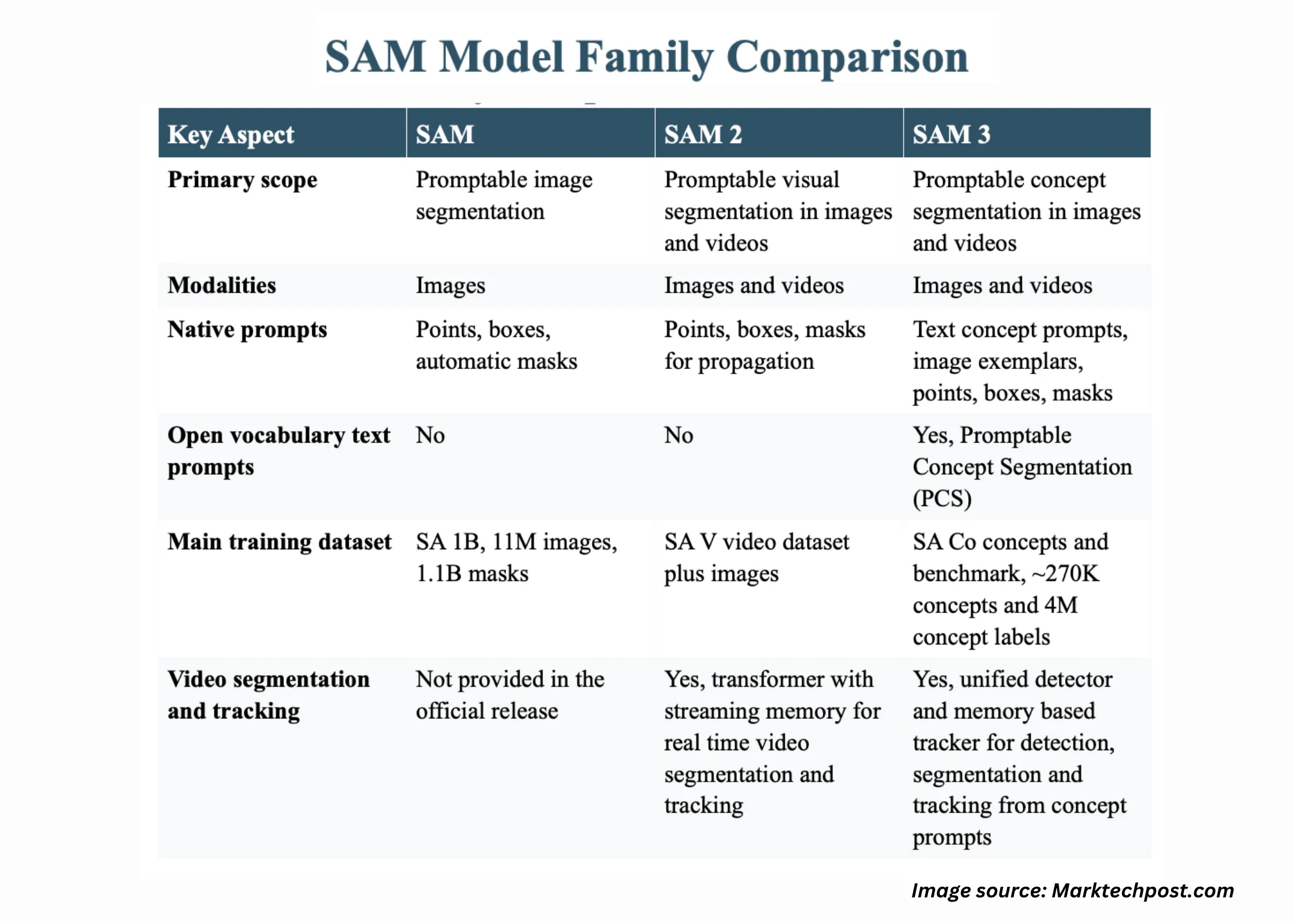

如何通过简单的提示,从大量图库和视频集中可靠地找到、分割和跟踪任何概念的所有实例?Meta AI团队刚刚发布了Meta Segment Anything Model 3,或称为SAM 3,这是一个开源的统一基础模型,用于图像和视频中的可提示分割,它直接在视觉概念上操作,而不是只操作像素。它可以从文本提示和视觉提示,如点、框和掩码中检测、分割和跟踪对象。与SAM 2相比,SAM 3可以全面地找到开放词汇概念的所有实例,例如在一个长视频中找到每一个“红色棒球帽”,使用一个单独的模型。

从视觉提示到可提示概念分割

早期的SAM模型专注于交互式分割。用户点击或划一个框,模型会生成一个单独的掩码。这种流程无法扩展到系统必须在大图像或视频集中找到概念所有实例的任务。SAM 3正式化了可提示概念分割(PCS),它接受概念提示,并返回图像和视频中每个匹配对象的实例掩码和稳定身份。

概念提示将简短的名词短语与视觉示例相结合。模型支持详细的表达式,如“黄色校车”或“穿红色的球员”,并且还可以使用示例裁剪作为正例或负例。文本提示描述了概念,而示例裁剪有助于消除细粒度的视觉差异。SAM 3还可以用作多模态大型语言模型中的视觉工具,这些模型生成较长的引用表达式,然后调用SAM 3进行蒸馏后的概念提示。

https://ai.meta.com/blog/segment-anything-model-3/?

架构、存在标记和跟踪设计

SAM 3模型有848M个参数,包括一个检测器和一个跟踪器,共享一个单一的视觉编码器。检测器是一个基于DETR的架构,它依赖于三个输入,文本提示、几何提示和图像示例。这使核心图像表示与提示接口分离,并使同一个骨干能够服务于许多分割任务。

SAM 3中的关键变化是存在标记。该组件预测每个候选框或掩码是否实际上对应于所需的概念。在文本提示描述相关实体时(例如,“一个穿白色的球员”和“一个穿红色的球员”)这一点尤为重要。存在标记减少了此类提示之间的混淆,并提高了开放词汇的准确性。识别,即分类候选者是否为概念,与定位(即预测框和掩码形状)分离。

对于视频,SAM 3重新使用了SAM 2中的transformer编码器解码器跟踪器,但将其紧密连接到新的检测器。跟踪器在帧之间传播实例身份,并支持交互式细化。解耦的检测器和跟踪器设计最大限度地减少了任务干扰,与更多数据和概念清洁扩展,并且仍然暴露了一个类似于早期Segment Anything模型的基于点的细化交互界面。

https://ai.meta.com/research/publications/sam-3-segment-anything-with-concepts/

SA-Co数据集和基准套件

为了训练和评估可提示概念分割(PCS),Meta推出了SA-Co系列数据集和基准。SA-Co基准包含270K个独特的概念,这是之前开放词汇分割基准中概念数量的50多倍。每个图像或视频都与名词短语配对,并为匹配每个短语的每个对象提供密集实例掩码,包括没有对象应匹配的负面提示。

相关的数据引擎自动标记了超过400万个独特的概念,如Meta所述,使SA-Co成为最大的高质量开放词汇分割语料库。该引擎结合了大型本体和自动检查,并支持硬负例挖掘,例如视觉上相似但语义上不同的短语。这种规模对于学习一个能够在真实场景中应对多种文本提示的模型至关重要。

图像和视频性能

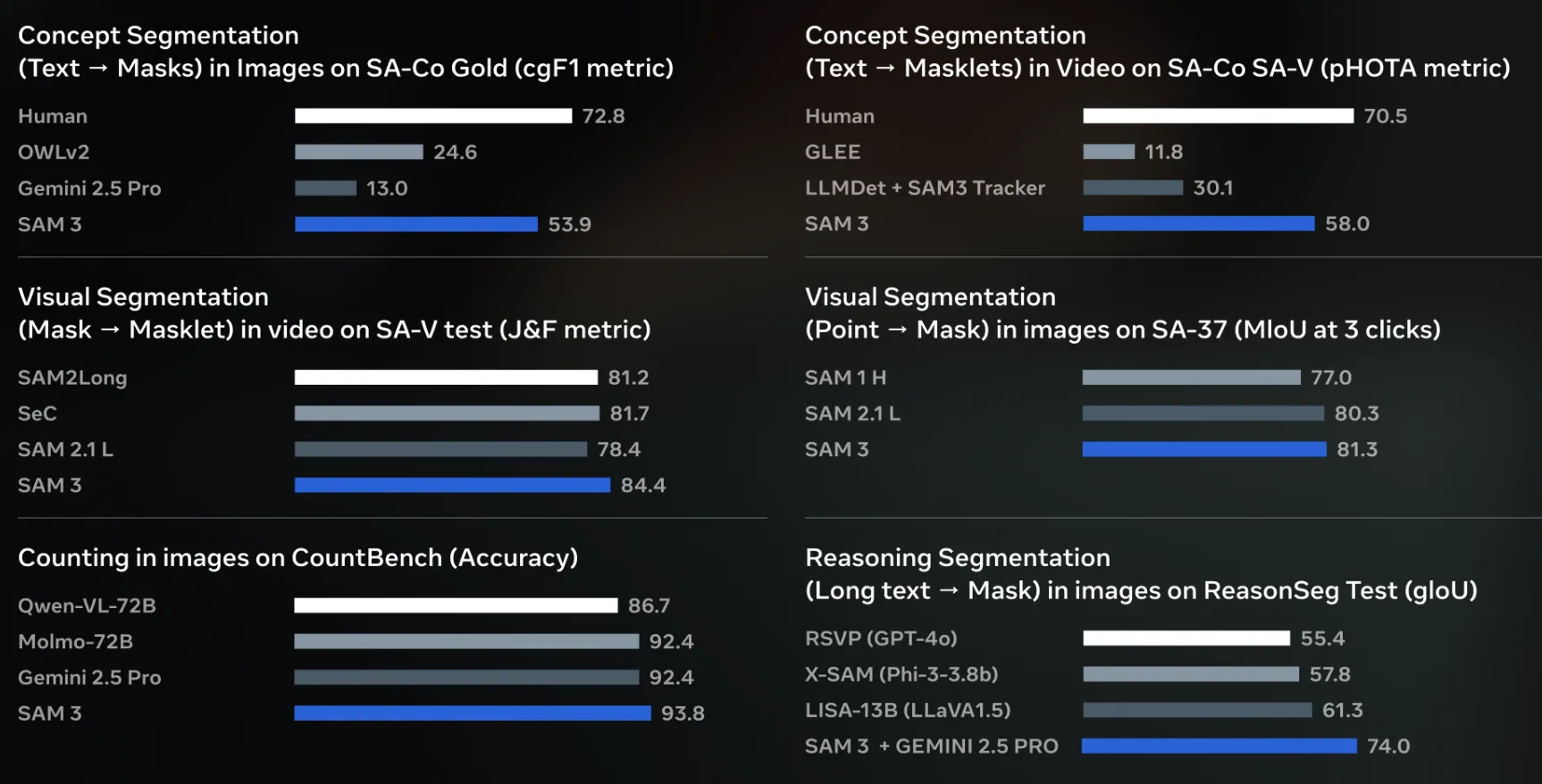

在SA-Co图像基准测试中,SAM 3达到了75%到80%的以cgF1衡量的人类性能。与OWLv2、DINO-X和Gemini 2.5等竞争系统相比,差距明显。例如,在SA-Co Gold框检测上,SAM 3报告了55.7的cgF1,而OWLv2达到了24.5,DINO-X达到了22.5,Gemini 2.5达到了14.4。这表明一个单一的自统一模型可以在开放词汇分割上优于专业检测器。

在视频中,SAM 3在SA-V、YT-Temporal 1B、SmartGlasses、LVVIS和BURST上进行了评估。在SA-V测试中,它达到了30.3的cgF1和58.0的pHOTA。在YT-Temporal 1B测试中,它达到了50.8的cgF1和69.9的pHOTA。在SmartGlasses测试中,它达到了36.4的cgF1和63.6的pHOTA,而在LVVIS和BURST中,它分别达到了36.3的mAP和44.5的HOTA。这些结果证实,单个架构可以同时处理图像PCS和长期视频跟踪。

https://ai.meta.com/research/publications/sam-3-segment-anything-with-concepts/

SAM 3作为数据为中心的标注平台基准测试机会

对于Encord等数据为中心的平台而言,SAM 3是他们在自标记和视频跟踪中现有SAM和SAM 2集成之后的自然下一步,这些集成已经让客户能够使用Encord的QA驱动型工作流程中的基础模型自动为超过90%的图像进行自动标注,具有较高的掩码精度。类似平台CVAT、SuperAnnotate和Picsellia正在使用Segment Anything风格的模型进行零样本标注、模型调优标注和MLOps管道标准化。SAM 3的可提示概念分割和统一的图像视频跟踪创造了明确的编辑和基准测试机会,例如,量化在从SAM 2转移到SAM 3的密集视频数据集或多媒体环境中 Encord类似堆栈的标签成本降低和质量提升。

主要结论

- SAM 3将图像和视频分割统一到一个848M参数的基础模型中,支持文本提示、示例、点框,用于可提示概念分割。

- SA-Co数据引擎和基准引入了大约270K个评估概念和超过400万个自动标注概念,使SAM 3的训练和评估堆栈成为可用的最大的开放词汇分割资源之一。

- SAM 3在先前开放词汇系统中取得了实质性改进,达到了大约75%到80%的SA Co上的人类cgF1,并在关键的SA-Co Gold检测指标上超过OWLv2和DINO-X超过一倍。

- 架构将基于DETR的检测器与带有存在头部的SAM 2风格的视频跟踪器解耦,这使SAM 3能够跨长视频进行稳定的实例跟踪,同时保持交互式SAM风格的细化。

评论

SAM 3推动了Segment Anything从可提示视觉分割到单个848M参数模型的可提示概念分割,统一了图像和视频。它利用SA-Co基准,其中包含大约27万个评估概念和超过400万个自动标注概念,在cgF1上接近75%到80%的人类性能。解耦的基于DETR的检测器和带有存在头部的SAM 2风格跟踪器使SAM 3成为代理和产品的实用视觉基础模型。总的来说,SAM 3现在是生产规模开放词汇分割的参考点。

查看论文、代码仓库和模型权重。欢迎查看我们的教程、代码和笔记本GitHub页面。也欢迎关注我们的Twitter,别忘了加入我们的10k+ ML SubReddit和订阅我们的时事通讯。等等!你在Telegram上吗?现在你可以在Telegram上加入我们了。

文章Meta AI发布Segment Anything Model 3 (SAM 3),用于图像和视频中的可提示概念分割最初出现在MarkTechPost。